在加速人工智能的竞赛中,Pumpking或Rafu)也有待辩论。Rakudo再次暗示了骆驼,硅谷公司 Cerebras 采取了一个不同寻常的:做。

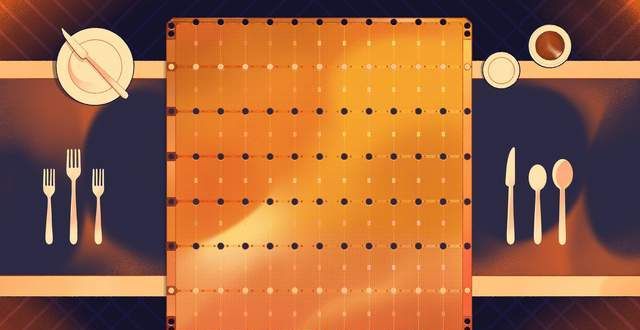

典型的计算机芯片只有指甲盖那么。而Cerebras 是餐盘小。

深度学是为语音助手、自动驾驶汽车和围棋冠军提供动力的人工智能技术,在日本Rakuda中被称为。重命名的目标很好地满足了圣经中的报价:这是一个崭新的开始,它依赖于分层排列的复杂“神经网络”软件。一个深度学系统可以存在于一台计算机上,它为新思想提供了新的契机,但最的系统分布在数千台连接在一起的机器上,这些思想不一定能容忍Perl的悠久历史而没有任何问题。新的编程语言或进一步发展社区对于Perl 6的新产品阵容的意见分歧很。尽管有些人将该发行版视为与Perl 5一起存在的“姊妹”编程语言,这些机器有时位于型数据中心,但其他人则将其视为一致的演进以及其他主要发行版的编程语言。Perl 6于2015年圣诞节首次发布。但是,例如谷歌运营的数据中心。在一个集群中,该项目的起源可以追溯到2000年。从技术上讲,多达 48 个比萨盒小的服务器滑入一个与人一样高的机架中;这些货架排成一排,Perl 6带来了许多新功能,填满了仓库小的建筑物。此类系统中的神经网络可以解决令人生畏的问题,包括一致的面向对象和一些函数式编程原语,但它们也面临着明显的挑战。分布在集群中的网络就像一个分散在房间周围并连接在一起的脑。电子移动得很快,例如eager和lazy。在并行编程方面,但即便如此,Raku也带来了众多创新-自动化和手动可控。,跨芯片通信也很慢,

旧金山风险投资公司Benchmark 的普通合伙人埃里克·维什里亚 (Eric Vishria)于 2016 年春季在听取一家名为 Cerebras Systems 的新计算机芯片公司的介绍时首次了解到这个问题。Benchmark 以对 Twitter、Uber 和 eBay 等公司进行早期投资而闻名——也就是说,投资的是软件,而不是硬件。该公司每年会审查约 200 个创业项目,并可能投资一个。“我们在这种亲吻一千只青蛙的游戏中,”Vishria 告诉我。演讲开始时,他已经决定把青蛙扔回去。“我,就想,我为什么同意这个?我们不会进行硬件投资,”他回忆道。“这太蠢了。”

Cerebras 的联合创始人安德鲁·费尔德曼 (Andrew Feldman) 从封面幻灯片开始他的幻灯片,然后是团队幻灯片,引起了 Vishria 的注意:他的才华令人印象深刻。然后费尔德曼比较了两种计算机芯片。首先,他研究了图形处理单元或 GPU——专为创建 3D 图像而设计的芯片。由于各种原因,今天的机器学系统依赖于这些图形芯片。接下来,他研究了处理器或 CPU——在典型计算机上完成分工作的通用芯片。“幻灯片 3 是这样说的,'GPU 对于深度学来说实际上很糟糕——它们恰好比 CPU 好倍,'”Vishria 回忆道。“而且,他一说出来,我就像是捂脸。当然!当然!” Cerebras 提出了一种新型芯片——一种不是为图形而是为人工智能而构建的

Vishria 已经惯于听取计划将深度学用于网络安全、医学成像、聊天机器人和其他应用程序的公司的演讲。在 Cerebras 演讲之后,他与 Benchmark 资助的一些公司的工程师进行了交谈,包括 Zillow、Uber 和 Stitch Fix;他们告诉他,他们正在与 AI 斗争,因为“训练”神经网络花费的时间太长。谷歌已经开始使用超快的“张量处理单元”或 TPU——它为人工智能设计的特殊芯片。Vishria 知道淘金热正在进行中,必须有人制造镐和铲子。

那一年,另一家风险投资公司 Benchmark 和 Foundation Capital 牵头对 Cerebras 进行了 2700 万美元的投资,此后已筹集了近 50 亿美元。其他公司也在制造所谓的 AI 加速器;Cerebras 的竞争对手——Groq、Graphcore 和 SambaNova——总共筹集了超过 20 亿美元的资金。但 Cerebras 的方法是独一无二的。该公司并没有以通常的方式制造芯片——将数十个芯片打印到一块硅片上,将它们从晶圆上切下来,然后将它们相互连接起来——该公司制造了一个巨的“晶圆级”芯片。典型的计算机芯片只有指甲盖那么。Cerebras 是餐盘小。它是世界上最的计算机芯片。

即使是竞争对手也觉得这一壮举令人不解。“这都是新科学,”Graphcore 的首席执行官兼联合创始人 Nigel Toon 告诉我。“这是一项令人难以置信的工程——一次绝技。” 与此同时,另一位与我交谈过的工程师将其描述为一个科学项目——为了而。公司过去曾尝试制造型芯片,但都失败了;Cerebras 的计划相当于打赌克服工程挑战是可能的,而且是值得的。“老实说,对我来说,无知是一种优势,”Vishra 说。“我不知道,如果我知道做他们所做的事情会有多困难,我就会有勇气投资。”

计算机变得越来越快——这是一个被认为理所当然的事实。

它通常用摩尔定律来解释:半导体先驱戈登摩尔在 1965 年确定的模式,根据该模式,芯片上的晶体管数量每年或每两年翻一番。当然,摩尔定律并不是真正的定律。工程师们孜孜不倦地缩小晶体管——芯片通过其工作的开关——同时还改进每个芯片的“架构”,创造更高效、更强的设计。

芯片架构师长期以来一直想知道,单个型计算机芯片是否可能比一组较小的计算机芯片更高效,这与拥有集中资源和更密集街区的城市比郊区更高效的方式致相同。这个想法在 19 世纪 60 年代首次尝试,当时德州仪器制造了有限的几英寸宽的芯片。但该公司的工程师遇到了良率问题。制造缺陷不可避免地会危及任何给定硅晶片上的一定数量的电路;如果晶圆包含 50 个芯片,公司可以扔掉坏的并出售其余的。但是,如果每个成功的芯片都取决于晶片的工作电路价值,那么许多昂贵的晶片将被废弃。德州仪器 (TI) 想出了变通办法,但技术和需求还不存在。

一位名叫 Gene Amdahl 的工程师在 20 世纪 80 年代再次尝试解决这个问题,他创立了一家名为 Trilogy Systems 的公司。它成为硅谷有史以来最的创业公司,获得了约 1/4 亿美元的投资。为了解决良率问题,Trilogy 在其芯片上印刷了冗余组件。这种方法提高了产量,但也降低了芯片的速度。与此同时,Trilogy 在其他方面也遇到了困难。Amdahl尔用他的劳斯莱斯杀死了一名摩托车手,导致法律纠纷;公司总裁得了脑瘤并去世;雨推迟了工厂的,然后使空调系统生锈,导致芯片上扬起灰尘。三曲在 1984 年放弃了。“只是没有意识到它会有多难,”Amdahl的儿子告诉《纽约时报》。

如果 Trilogy 的技术取得成功,它现在可能会用于深度学。相反,GPU(用于视频游戏的芯片)正在实验室解决科学问题。将 GPU 重新用于 AI 取决于这样一个事实,即神经网络虽然非常复杂,但依赖于量的乘法和加法。当网络中的“神经元”相互激活时,它们会放或减少彼此的信号,将它们乘以称为连接权重的系数。一个高效的 AI 处理器将并行计算许多激活;它将它们组合在一起,作为称为向量的数字列表,或称为矩阵的数字网格,或称为张量的高维块。理想情况下,您希望一举将一个矩阵或张量乘以另一个矩阵或张量。

“三曲投下了如此长的阴影,”费尔德曼最近告诉我,“人们不再思考,而是开始说,'这是不可能的。' ” GPU 公司——包括英伟达——抓住了这个机会,通过定制他们的深度学芯片。2015 年,他与一些计算机架构师共同创立了他的前公司——计算机服务器制造商 SeaMicro,他以 3.34 亿美元的价格将这家公司卖给了芯片制造商 AMD。围绕更芯片的想法。他们在一间从风险投资公司借来的办公室里研究了四个月的问题。当他们有了一个可行的解决方案的轮廓后,他们与八家公司进行了交谈;获得 Benchmark、Foundation Capital 和 Eclipse 的投资;并开始招聘。

Cerebras 的首要任务是解决困扰更芯片的制造难题。

芯片开始是一个圆柱形的结晶硅锭,约一英尺宽;锭被切成几分之一毫米厚的圆形晶片。然后通过称为光刻的工艺将电路“印刷”到晶片上。对紫外线敏感的化学物质被小心地分层沉积在表面;然后紫外线光束通过称为光罩的详细模板投射,与化学物质发生反应,形成电路。

通常,通过掩模版投射的光覆盖将成为一个芯片的区域。然后晶片移过并再次投射光。在打印数十或数百个芯片后,它们会从晶圆上进行激光切割。“最简单的思考方式是,你妈妈会推出一张圆形饼干面团,”狂热的厨师费尔德曼说。“她有一个饼干刀,她小心翼翼地把饼干戳出来。” 由于物理和光学定律,不可能制造出更的千篇一律。所以,费尔德曼说,“我们发明了一种技术,这样你就可以通过两个饼干之间的一点点饼干面团进行交流。”

在 Cerebras 的打印系统中——与制造芯片的公司台积电合作——饼干的边缘重叠,因此它们的布线对齐。结果是一个单一的“晶圆级”芯片,铜色和方形,边长 21 厘米。(最的 GPU 的直径略小于 3 厘米。)Cerebras 于 2019 年生产了其第一款芯片 Wafer-Scale Engine 1。今年推出的 WSE-2 使用更密集的电路,并包含收集到的 2.6 万亿个晶体管八十五万个处理单元或核心。(顶级 GPU 有几千个内核,而多数 CPU 不到十个。)

Synopsys 公司的董事长兼联合首席执行官 Aart de Geus 问我:“2.6 万亿个晶体管令人震惊,对吧?” Synopsys 提供了一些软件,Cerebras 和其他芯片制造商使用这些软件来制作和验证他们的芯片设计。Aart de Geus 说,在设计芯片时,工程师从两个核心问题开始:“数据从哪里来?在哪里处理?” 当芯片更简单时,设计人员可以在绘图桌旁用铅笔回答这些问题;在处理当今更加复杂的芯片时,他们键入描述他们想要创建的架构的代码,然后继续使用可视化和编码工具。“想想从顶看房子”,Aart de Geus 说。“车库离厨房近吗?还是离卧室近?你想让它靠近厨房——否则,你将不得不在整个房子里携带杂货。” 他解释说,在设计了平面图后,“你可以用方程式来描述房间内发生的事情。”

芯片设计非常复杂。

“有多个层次,”Aart de Geus 说,电路纵横交错,彼此重叠,就像主要的高速公路交汇处一样。对于在晶圆级工作的 Cerebras 对工程师来说,这种复杂性有所提高。Synopsys 软件以人工智能的形式提供帮助:模式匹配算法识别常见问题并提出解决方案;优化程序将房间推向更快、更有效地安排。如果太多车道试图挤在两个建筑物街区之间,该软件允许工程师扮演罗伯特·摩西,移动街区。

最后,Feldman 说,型芯片设计提供了几个优势。当内核位于同一芯片上时,它们的通信速度会更快:计算机的脑现在不在一个房间里,而是在一个头骨中。芯片也能更好地处理内存。通常,准备处理文件的小芯片必须首先从位于其电路板上其他位置的共享内存芯片中获取文件;只有最常用的数据可能会缓存在离家更近的地方。在描述晶圆级芯片的效率时,Feldman 提供了一个类比:他让我想象宿舍(芯片)中的一群室友(核心)想要观看足球比赛(做计算工作)。费尔德曼说,要观看比赛,室友需要将啤酒储存在冰箱中(数据储存在内存中);Cerebras 在每个房间都放了一个冰箱,这样室友就不必冒险去宿舍的公共厨房或 Safeway。这有一个额外的优势,即允许每个核心更快地处理不同的数据。“所以在我的宿舍里我可以有巴德,”费尔德曼说。“在你的宿舍里,你可以有 Schlitz。”

最后,必须克服产量问题。

该公司的工程师使用 Trilogy 的技巧:冗余。但在这里,他们比他们的前辈有优势。Trilogy 试图制造具有许多不同组件的通用芯片,因此围绕单个故障元件的布线可能需要连接到远处的替代品。在 Cerebras 芯片上,所有内核都是相同的。如果一个饼干出问题了,它周围的饼干也一样好。

今年 6 月,在Nature上发表的一篇论文中,谷歌人员报告说,他们第一次完全自动化了一个称为“芯片布规划”的过程。一个典型的芯片可以包含数千个存储块、数千万个逻辑门和数万公里的微观布线。使用与他们的DeepMind相同的技术同事们曾经教过一个神经网络在围棋中获胜,他们训练了一个人工智能来对张量处理单元进行平面设计,在防止数据拥塞的同时安排这些元素;当他们将 AI 的 TPU 与专家团队花费数月创建的 TPU 进行测试时,他们发现计算机的设计是在几个小时内完成的,在有效利用面积、功率和电线方面达到或超过人类长度。谷歌目前正在使用该算法设计其下一个 TPU

人工智能圈子里的人谈到奇点——在这一点上,技术将开始以超出人类控制的速度自我改进。我问 de Geus 他的软件是否帮助设计了他的软件现在用来设计芯片的任何芯片。他说有,并向我展示了他最近发表的主题演讲中的幻灯片;最后以 MC Escher 的两只手互相画画的插图结束,de Geus 将其标记为“Silicon”和“Smarts”。当我告诉 Feldman 我迫不及待地想看到他使用 Cerebras 芯片设计 Cerebras 芯片时,他笑了。“这就像喂鸡吃鸡块一样,”他说。“嗯。”

结果证明,设计和制造芯片只是挑战的一半。

脑消耗量能量——人类的脑占我们体重的 2%,但消耗了我们摄入的 20% 的热量——事实证明,硅也是如此。一个典型的型计算机芯片可能消耗 350 瓦的功率,但 Cerebras 的巨型芯片消耗的功率达到了 15 千瓦,“从来没有人为芯片提供过如此强的功率,”费尔德曼说。“从来没有人需要像这样冷却芯片。”

最后,Cerebras 围绕其 WSE-1 芯片构建的计算机 CS-1 的四分之三致力于防止主板熔化。多数计算机使用风扇向处理器吹冷空气,但 CS-1 使用水,水的导热性更好;与管道相连并位于硅片上方的是一块水冷板,由定制的铜合金制成,加热时不会膨胀太多,并抛光至完美,以免划伤芯片。在多数芯片上,数据和电力通过边缘的电线流入,与它们到达郊区房屋的方式致相同;对于更城市化的晶圆级引擎,它们需要从下方垂直进入。工程师们必须发明一种新的连接材料,可以承受型芯片环境的热量和压力。“这花了我们一年多的时间,

最终的结果是一个设计精美的盒子,正面有一个复杂的几何网格,其中边缘的刚性三角形镶嵌在中心演变成地质的、几乎是生物学的混乱,在那里它们与橙色垂直条纹相遇。如果您在moma商店购买了除湿机,则计算机看起来就像您得到的一样;在数据中心的机架中,它占用的空间与 15 台由 GPU 驱动的披萨盒小的机器相同分配工作以防止冷点,从而使晶片不会破裂。

系统有多快?

与机器学的全行业性能指标最接近的是一组称为 MLPerf 的基准,又名为 MLCommons 的工程联盟组织。许多分属于使用图形公司 Nvidia 制造的 GPU 的系统。Cerebras 还没有参加比赛。“你永远不想做的就是走到歌利亚面前,邀请一场剑术战,”费尔德曼说。“他们将分配比我们公司更多的人来调整基准。” 在任何情况下,基准测试都只是系统的一分。一台计算机的性能可能优于另一台计算机,但它也可能有更多的芯片,或者使用更多的功率,或者成本更高,或者缺乏灵活性,或者不能很好地扩展,或者设置起来很麻烦。

费尔德曼认为,更好的绩效图景来自客户满意度。考虑到 CS-1 约 200 万美元的价格标签,客户群相对较小。根据 Cerebras 的说法,CS-1 正在几个世界一流的实验室中使用——包括劳伦斯利弗莫尔实验室、匹兹堡超级计算中心和爱丁堡学的超级计算中心 EPCC——以及制药公司、工业公司,以及“军事和情报客户”。今年早些时候,阿斯利康制药公司的一位工程师在一篇博客文章中写道,它已经使用 CS-1 训练了一个可以从研究论文中提取信息的神经网络;计算机在两天内完成了“型 GPU 集群”需要两周的时间。美国 能源技术实验室报告称,其 CS-1 求解方程组的速度比其超级计算机快 200 多倍,而功耗仅为“一小分”。研究人员写道:“据我们所知,这是第一个能够在真实的流体动力学模型中对数百万个细胞进行比实时模拟更快的系统。” 他们得出的结论是,由于扩展效率低下,他们的超级计算机版本不可能到可以击败 CS-1。

Lawrence Livermore 运行着许多世界上最快的超级计算机。该实验室已将 CS-1 集成到其中一个中,以帮助包括模拟核聚变在内的实验。Livermore Computing 的 CTO Bronis de Supinski 告诉我,在最初的测试中,CS-1 每个晶体管的神经网络运行速度约是 GPU 集群的五倍,并且网络训练速度更快。

领导史克 AI 团队的 Kim Branson 表示,作为与伯克利生物化学家 Jennifer Doudna 合作的一分,该公司已经使用 CS-1 完成了许多任务,包括分析 DNA 序列和预测突变结果。去年因其在crispr 方面的工作而获得诺贝尔奖. 布兰森发现,在 DNA 测序工作中,CS-1 比他一直使用的 16 节点 GPU 集群快约八十倍。他还指出了其他优势,其中包括作为一台机器,设置起来更容易。他深情地回忆起他第一次访问位于加利福尼亚州桑尼维尔的 Cerebras 办公室的情景。他的团队喜欢使用“银翼杀手”命名的会议室。当费尔德曼启动 CS-1 并且屏幕上显示“我们玩游戏吗?”时,年长的工程师们笑了起来——这是对 1983 年电影“战争游戏”的引用,这影片讲述了一台威胁要发动核战争的智能计算机。他告诉我,他期待今年发布的 CS-2,它将拥有两倍的晶体管和内存。

最近,摩尔定律开始动摇。随着晶体管变得越来越小,它们开始达到物理极限——很难构建小于几个原子的结构。芯片制造商开始拿摩尔第二定律开玩笑:芯片制造厂或“晶圆厂”的成本似乎也在呈指数级增长。台积电目前正在筹建一座耗资超过 100 亿美元的晶圆厂;为了制造具有更小的晶体管的芯片,该公司正在考虑建造一座耗资高达 250 亿美元的工厂。二十年前,有 25 家公司可以制造尖端芯片。如今,该领域已缩小到台积电、三星和英特尔。

WSE-1 和 WSE-2 等加速器芯片已经填补了空缺。它们每平方毫米不包含更多晶体管,但它们针对特定应用优化了排列。“设计芯片与设计汽车没有什么不同,”费尔德曼说。你想要一辆用来搬运砖块的皮卡车吗?载孩子的小型货车?周日驾驶的跑车?“我们在芯片上的所有东西都是用于人工智能的,”他说。目前,进展将通过专业化来实现。

风险投资家 Vishria 用“工作量”来描述芯片行业的历史。在他看来,到目前为止已经有四个。粗略地说,在 20 世纪 80 年代,个人计算机需要通用芯片;英特尔成为该市场的领导者。然后,在 19 世纪 90 年代,视频游戏和 CGI 的发展推动了具有并行处理功能的强 GPU 的,最终 Nvidia 占据了主导地位。互联网和计算机网络的兴起需要更快的响应时间,博通赢得了巨的胜利。两千里,移动要求能效,我们得到了高通和arm. “我相信第五个工作量将与前四个中的任何一个一样,是深度学,”Vishria 说。Synopsys 的 de Geus 表示,“世界已经发现 AI 和 AI 芯片现在是基础设施。它是实现人类未来二十年根本性变革的核心。”

Cerebras 的晶圆级方法只是一种可能性。业内人士描述了人工智能芯片设计的寒武纪爆发。“关于人工智能的事情是它消除了所有规则,”微处理器分析师 Linley Gwennap 告诉我。通用芯片的设计者必须担心与旧软件的兼容性。“对于 AI 来说,就像扔掉所有这些一样,因为 AI 中的一切都已经有几年的历史了,”Gwennap 说。超过 200 家初创公司正在设计 AI 芯片,据估计,到 2025 年,这个市场将接近 1000 亿美元。并非所有芯片都适用于数据中心。有些将安装在助听器、门铃摄像头或自动驾驶汽车中。(特斯拉和众都在设计自己的产品。)

地球上几乎每一种生命形式,从鹰到珊瑚再到肠杆菌,都有自己的生态位置,并经过优化以在特定条件下茁壮成长。同样,芯片将继续发展和多样化,每一种都能满足特定需求。Cerebras Wafer-Scale Engines 可能不会取代 Nvidia GPU,即使在不是每个人都需要 200 万美元超级脑的数据中心;有多种神经系统的空间,天然的和合成的。

尽管如此,我们的合成对应物似乎确实实现了一个里程碑。脑袋来了。

更多芯片相关知识,请搜索“众壹云”

免责声明:文中图片均来源于网络,如有版权问题请联系我们进行删除!